Aktualisiert July 2025 : Beenden Sie diese Fehlermeldungen und beschleunigen Sie Ihr Computersystem mit unserem Optimierungstool. Laden Sie es über diesen Link hier herunter.

- Laden Sie das Reparaturprogramm hier herunter und installieren Sie es.

- Lassen Sie es Ihren Computer scannen.

- Das Tool wird dann Ihren Computer reparieren.

Der Begriff “Daten” ist uns nicht neu. Es ist eines der wichtigsten Dinge gelehrt, wenn Sie sich für Informationstechnologie und Computer entscheiden. Wenn Sie sich erinnern können, werden die Daten als die Rohform der Information betrachtet. Obwohl bereits seit einem Jahrzehnt vorhanden, ist der Begriff Big Data heutzutage ein Begriff. Wie aus dem Begriff, Lasten und Lasten von Daten ersichtlich, ist Big Data und kann auf unterschiedliche Weise mit verschiedenen Methoden und Werkzeugen verarbeitet werden, um benötigte Informationen zu beschaffen. Dieser Artikel spricht über die Konzepte von Big Data unter Verwendung der 3 V’s, die von Doug Laney, einem Pionier auf dem Gebiet des Data Warehousing, erwähnt werden, der das Feld der (Information Economics) initiiert hat.

Bevor Sie fortfahren, möchten Sie vielleicht unsere Artikel über die Grundlagen von Big Data und Big Data Usage lesen, um das Wesentliche zu verstehen. Sie könnten sich zu diesem Beitrag addieren, um weitere Erläuterungen zu Big Data-Konzepten zu erhalten.

Große Daten 3 Vs

Wir empfehlen die Verwendung dieses Tools bei verschiedenen PC-Problemen.

Dieses Tool behebt häufige Computerfehler, schützt Sie vor Dateiverlust, Malware, Hardwareausfällen und optimiert Ihren PC für maximale Leistung. Beheben Sie PC-Probleme schnell und verhindern Sie, dass andere mit dieser Software arbeiten:

- Download dieses PC-Reparatur-Tool .

- Klicken Sie auf Scan starten, um Windows-Probleme zu finden, die PC-Probleme verursachen könnten.

- Klicken Sie auf Alle reparieren, um alle Probleme zu beheben.

Daten, in ihrer riesigen Form, die mit verschiedenen Mitteln gesammelt wurden, wurden früher ordnungsgemäß in verschiedenen Datenbanken abgelegt und nach einiger Zeit gelöscht. Als sich herausstellte, dass es umso einfacher ist, mit den richtigen Tools unterschiedliche und relevante Informationen herauszufinden, begannen Unternehmen, Daten über einen längeren Zeitraum zu speichern. Dies ist wie das Hinzufügen neuer Speichergeräte oder die Verwendung der Cloud, um die Daten in beliebiger Form zu speichern: Dokumente, Tabellenkalkulationen, Datenbanken und HTML, etc. Es wird dann mit Werkzeugen, die große Datenmengen verarbeiten können, in die richtigen Formate gebracht.

HINWEIS: Der Umfang von Big Data beschränkt sich nicht auf die Daten, die Sie in Ihren Räumlichkeiten und der Cloud sammeln und speichern. Sie kann Daten aus verschiedenen anderen Quellen enthalten, einschließlich, aber nicht beschränkt auf öffentlich zugängliche Objekte.

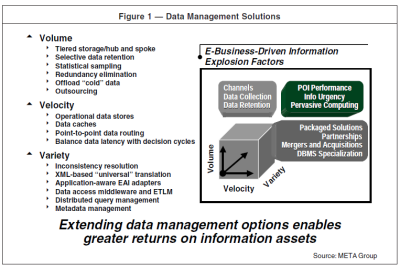

Das 3D-Modell der großen Daten basiert auf den folgenden V’s:

- Umfang: bezieht sich auf die Verwaltung der Datenspeicherung

- Geschwindigkeit: bezieht sich auf die Geschwindigkeit der Datenverarbeitung

- Vielfalt: bezieht sich auf die Gruppierung von Daten verschiedener, scheinbar unzusammenhängender Datensätze

In den folgenden Abschnitten wird die Modellierung von Big Data erläutert, indem über jede Dimension (jedes V) im Detail gesprochen wird.

A] Große Datenmengen

Nach einem von der Meta Group veröffentlichten Whitepaper sehen Teile der Daten bei steigendem Datenvolumen unnötig aus. Darüber hinaus heißt es, dass nur die Datenmenge aufbewahrt werden soll, die die Unternehmen verwenden wollen. Andere Daten können verworfen werden oder wenn die Unternehmen nicht bereit sind, vermeintlich unwichtige Daten loszulassen, können sie auf unbenutzte Computergeräte und sogar auf Bänder ausgegeben werden, so dass die Unternehmen nicht für die Speicherung solcher Daten bezahlen müssen.

Ich habe vermeintlich unwichtige Daten verwendet, weil auch ich der Meinung bin, dass Daten jeder Art in Zukunft – früher oder später – von jedem Unternehmen benötigt werden können und daher für eine gewisse Zeit aufbewahrt werden müssen, bevor man weiß, dass die Daten tatsächlich unwichtig sind. Persönlich dumpfe ich ältere Daten auf Festplatten aus früheren Jahren und manchmal auch auf DVDs. Die Hauptcomputer und der Cloud-Speicher enthalten die Daten, die ich für wichtig halte und von denen ich weiß, dass ich sie verwenden werde. Auch unter diesen Daten gibt es einmal verwendete Daten, die nach einigen Jahren auf einer alten Festplatte landen können. Das obige Beispiel dient nur Ihrem Verständnis. Es wird nicht auf die Beschreibung von Big Data passen, da die Menge im Vergleich zu dem, was die Unternehmen als Big Data wahrnehmen, ziemlich gering ist.

B] Geschwindigkeit in großen Daten

Die Geschwindigkeit der Datenverarbeitung ist ein wichtiger Faktor, wenn es um Konzepte von Big Data geht. Es gibt viele Websites, insbesondere E-Commerce. Google hatte bereits zugegeben, dass die Geschwindigkeit, mit der eine Seite geladen wird, für eine bessere Platzierung unerlässlich ist. Abgesehen von der Rangliste ist die sp eed bietet den Nutzern auch Komfort beim Einkaufen. Gleiches gilt für Daten, die zu anderen Zwecken verarbeitet werden.

Während man über Geschwindigkeit spricht, ist es wichtig zu wissen, dass sie jenseits einer höheren Bandbreite liegt. Es kombiniert leicht verwertbare Daten mit verschiedenen Analysewerkzeugen. Leicht verwertbare Daten bedeuten einige Hausaufgaben, um Strukturen von Daten zu schaffen, die einfach zu verarbeiten sind. Die nächste Dimension – Varietät, verbreitet weiteres Licht darauf.

C] Vielfalt der großen Daten

Wenn es Lasten und Lasten von Daten gibt, wird es wichtig, diese so zu organisieren, dass die Analysewerkzeuge die Daten leicht verarbeiten können. Es gibt auch Werkzeuge, um Daten zu organisieren. Beim Ablegen können die Daten unstrukturiert und in beliebiger Form vorliegen. Es liegt an Ihnen herauszufinden, welche Beziehung es zu anderen Daten mit Ihnen hat. Sobald Sie die Beziehung herausgefunden haben, können Sie die entsprechenden Werkzeuge aufnehmen und die Daten in die gewünschte Form für eine strukturierte und sortierte Ablage umwandeln.

Zusammenfassung

Mit anderen Worten, das 3D-Modell von Big Data basiert auf drei Dimensionen: USABLE Daten, die Sie besitzen; korrekte Kennzeichnung der Daten; und schnellere Verarbeitung. Wenn diese drei gepflegt werden, können Ihre Daten leicht verarbeitet oder analysiert werden, um herauszufinden, was Sie wollen.

Das oben Gesagte erklärt beide Konzepte und das 3D-Modell von Big Data. Die im zweiten Absatz verlinkten Artikel werden Ihnen zusätzliche Unterstützung bieten, wenn Sie das Konzept noch nicht kennen.

Wenn Sie etwas hinzufügen möchten, kommentieren Sie es bitte.

EMPFOHLEN: Klicken Sie hier, um Windows-Fehler zu beheben und die Systemleistung zu optimieren